데이터 마이닝이란?

대량의 데이터(광물)에서 유용한 정보와 패턴(자원)을 찾기 위해 채굴이 필요.

이렇게 채굴된 정보와 패턴으로 통찰력을 얻고, 의사결정을 진행

텍스트 데이터 -> 텍스트 마이닝

이미지 데이터 -> 이미지 마이닝

일반적인 데이터 -> 데이터 마이닝

즉, 데이터 마이닝이란 특정 데이터에 한정하지 않고

대용량의 데이터 내에 존재하는 관계, 패턴, 규칙을 탐색

=> 이로부터 유용한 지식을 추출하는 과정 (텍스트 마이닝의 큰 개념)

* 데이터 선택 -> 전처리 -> 데이터 변환 -> 데이터 마이닝 -> 해석 및 평가

데이터 마이닝의 중요성

=> 아래의 과정에서 / 과정을 위해서 데이터 마이닝을 사용함!

- 의사결정 강화 : 데이터로부터 통찰력을 얻어 전략 계획 수립

- 효율성 증대 : 비용 절감, 리스크 관리

- 고객 이해 : 고객의 요구 행동 이해, 맞춤형 서비스 제품 개발

- 시장 동향 예측

데이터 마이닝 사례

- 코로나19 데이터 마이닝

: 코로나의 흐름을 추적하기 위해 감염자 수, 회복률, 백신 접종 현황, 인구 통계학 정보 등이 사용됨

=> 백신 효과, 바이러스 추적 등 의사 결정에 활용

- 실시간 GPS 데이터를 통한 최적 교통 정보 도출

: 실시간 차량의 위치 데이터, 움직이는 물체의 속도, 이동 방향 등의 데이터 사용

=> 어떤 경로로 갈 것인지, 교통 체증 완화 전략 등 의사 결정에 활용

- 구글 검색어 기반 독감 예보

: 구글에 검색하는 유행성 질병 검색어 데이터 활용

특정 조건의 검색어 정보 활용 (시간대별, 지역별)

- DNA 데이터를 통한 범죄자 추적

: 여러 사람의 DNA 데이터베이스와 수집한 비교 대상의 DNA 유사도 분석

데이터 마이닝 프로세스

데이터 수집 및 통합

- 목적으로 하는 문제를 풀기 위한 데이터 수집

-> 다양한 분석을 위해 서로 상이한 종류의 데이터 수집 (전문가의 통찰 필요)

- 데이터 통합 과정

: 일관된 형식으로 데이터 통합

ex. 이모티콘, DOM 구조 등 제거

- 데이터 품질 관리

: 데이터 검증 및 정화(오류, 중복 수정 및 제거)

: 완결성 검사(누락 데이터 핸들링)

데이터 전처리

: 데이터를 분석하기 위한 가장 초기 과정이며 중요한 첫 단추!

- 노이즈 및 오류 제거 : 이상치 확인. 수집 과정에서의 오류 데이터 확인

- 데이터 정규화 : 데이터의 스케일 통합

- 등

데이터 마이닝 기법 적용

-> 데이터 마이닝은 하나의 데이터에만 타겟팅한 주제가 아님!!

즉, 어떤 데이터를 어떻게 사용할 것인지 모두 다름

=> 수집한 데이터에 특화된 데이터 분석 방법론 적용

-> 비슷한 데이터 분석 사례 확인

ex. Kaggle에서 비슷한 데이터를 찾아서 분석한 선례를 찾아봄

* 주로 사용하는 마이닝 기법은

분류, 클러스터링, 예측, 잠재적 의미 표면화 등

결과 분석

데이터를 통해 인사이트를 얻고, 이를 바탕으로 의사 결정과 같은 과정에 사용

주의할 점은..

모델 평가 과정 시 모델을 평가하는 평가 수치가 의사 결정에 도움이 되는 평가인지 판단,

평가한 데이터가 의미 있는 데이터인지 확인 필요!

평가과정없이 사람의 직관과 판단이 들어가야 한다면, 원본 데이터에 편향이 없는지, 그 직관에 위험성은 없는지 등 고려 필요

데이터 웨어하우스

대기업에서 데이터를 관리할 때, 다양한 부서 존재

-> 이때마다 데이터 호출 인터페이스를 각각 따로 만든다면 너무 많은 비용 필요

-> 이렇게 데이터의 흐름이 엉켜있는 형태를 거미집 현상(Spider Web)이라고 함!

=> 이걸 효율적으로 컨트롤할 수 있는 것이 데이터 웨어하우스 (데이터가 모이는 창고)

데이터 웨어하우스에 저장하는 것

: 조직이 수집한 모든 데이터 (과거의 정보도 포함)

정형 데이터 + 비정형 데이터

ex. 원천 데이터, 사용 로그, 모델 학습에 쓰일 전처리된 데이터 등

데이터 웨어하우스 (DW) VS 데이터 베이스 (DB)

데이터 베이스 (DB)

: 실시간 데이터 처리와 트랜잭션 관리에 중점을 둠

: 일상적인 업무 및 응용 프로그램에 필요한 현재의 데이터를 저장 및 관리

-> 데이터의 신속한 read와 write의 목적

- 데이터 소비처 or 생산처에서 만들어지고 관리

- 다수의 사용자들이 동시 사용 가능

데이터 웨어하우스 (DW)

: 대규모 데이터를 통합, 분석, 보고하며, 과거의 데이터도 포함하고 있음

- DB의 데이터가 주기적으로 모여 만들어짐

- 조직 내 특정 그룹의 사용자에게만 제한

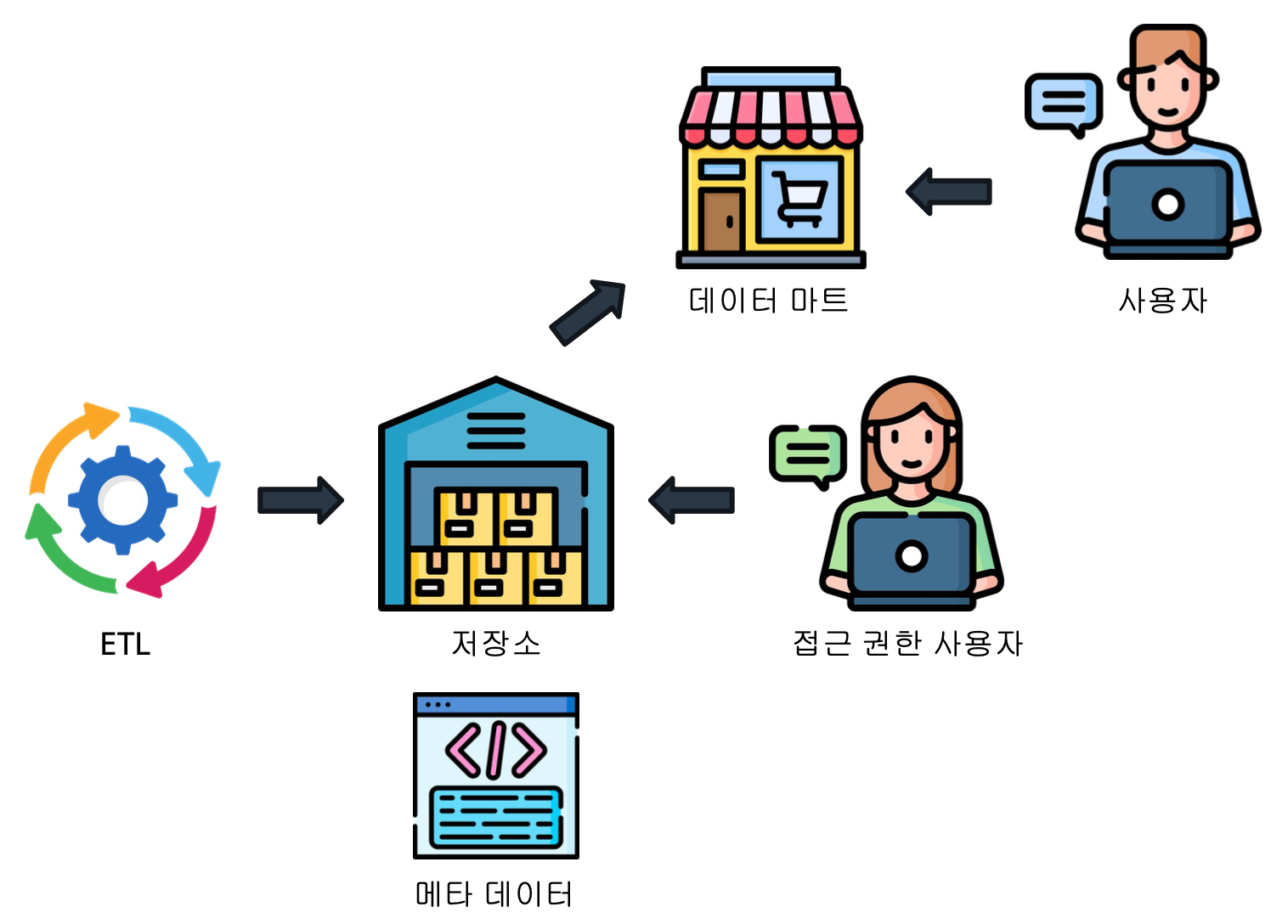

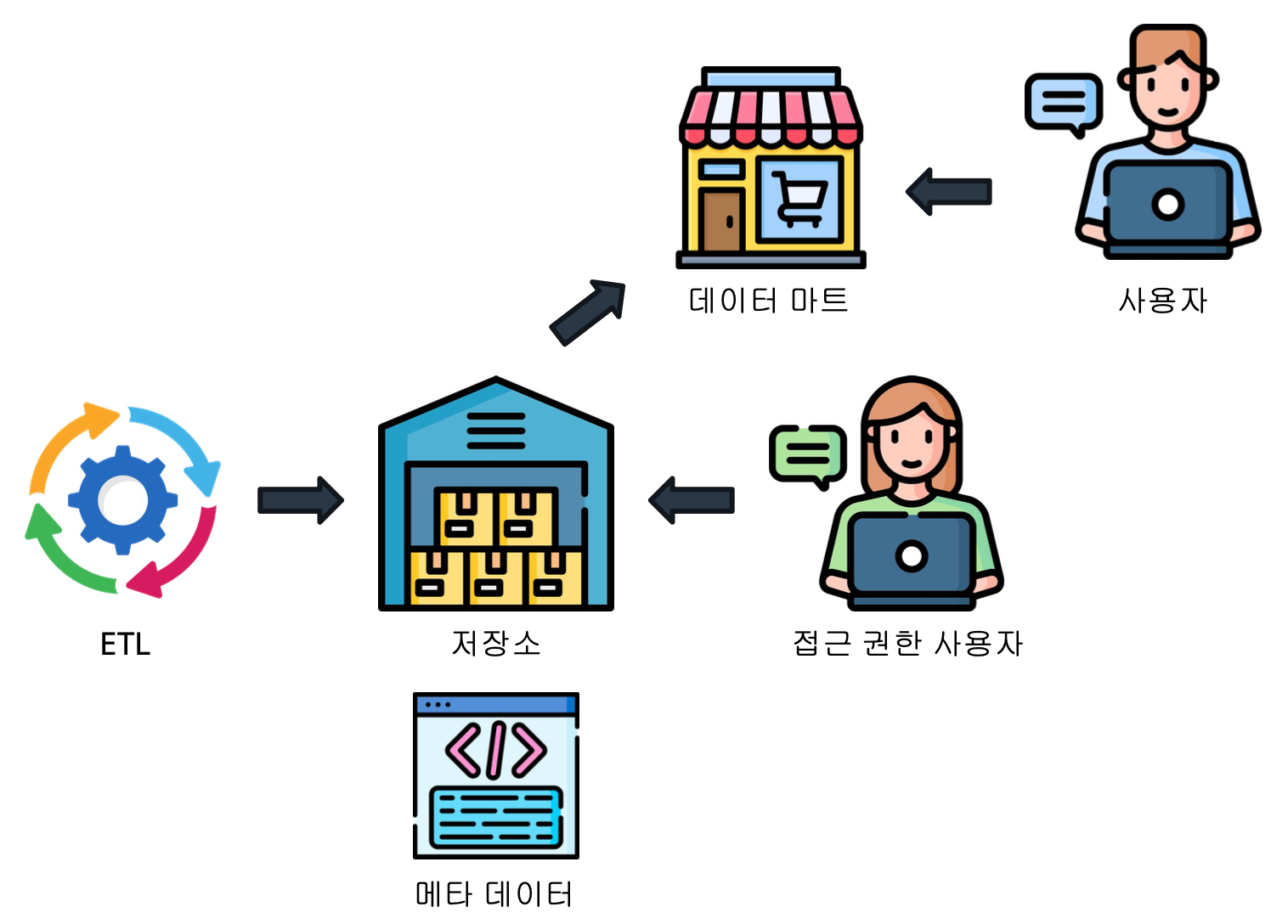

데이터 웨어하우스의 구성 요소

ETL (Extract, Transform, Load)

- Extract : 원천 데이터에서 데이터 추출

- Transform : 저장할 형태에 맞춰 변형

- Load : 중앙 데이터 저장소로 적재

중앙 데이터 저장소

: ETL된 데이터가 쌓이는 저장소

메타 데이터

: 데이터가 어디에서 왔는지, 어디에 저장되었는지 등 추가 정보

원천 데이터의 장소, 중앙 데이터 저장소의 크기 및 구성 방법 등

접근

: 사용자의 데이터 저장소와의 상호작용 지원

데이터 마트 (Data Mart)

데이터 웨어하우스에서는 요청에 맞는 작은 데이터 집합을 제공

-> 이를 데이터 마트라고 함

(데이터 웨어하우스에는 접근할 수 없지만, 과거의 데이터를 보고 싶어하는 사람들에게 제공)

데이터 마트의 특징

- 부서 중심적 & 주제 중심적

: 특정 부서나 특정 주제에 맞춰 데이터가 설계됨

: 항상 준비된 것이 아니라 주제에 맞는 부서의 요청이 있을 때 만들어짐

- 데이터 집중도가 높아짐

: 관련 있는 데이터만 집중적으로 포함

: 사용자 그룹이 필요로 하는 정보를 빠르고 쉽게 확인 가능

- 효율적 운영 및 사용자 친화성

: 필요한 데이터에 대해서 분석 진행 가능

'STUDY > DevCourse' 카테고리의 다른 글

| [데브코스][데이터 분석] 추천 시스템과 추천 시스템 알고리즘 (1) | 2024.05.16 |

|---|---|

| [데브코스][데이터 분석] 데이터 마이닝 실습 (0) | 2024.05.16 |

| [데브코스][데이터 분석] 딥러닝 모델을 활용한 문장 분류 실습 (1) | 2024.05.15 |

| [데브코스][데이터 분석] 자연어 처리 & 문장 분류 (0) | 2024.05.15 |

| [데브코스][데이터 분석] 토픽 모델링과 워드 클라우드 (1) | 2024.05.15 |

데이터 마이닝이란?

대량의 데이터(광물)에서 유용한 정보와 패턴(자원)을 찾기 위해 채굴이 필요.

이렇게 채굴된 정보와 패턴으로 통찰력을 얻고, 의사결정을 진행

텍스트 데이터 -> 텍스트 마이닝

이미지 데이터 -> 이미지 마이닝

일반적인 데이터 -> 데이터 마이닝

즉, 데이터 마이닝이란 특정 데이터에 한정하지 않고

대용량의 데이터 내에 존재하는 관계, 패턴, 규칙을 탐색

=> 이로부터 유용한 지식을 추출하는 과정 (텍스트 마이닝의 큰 개념)

* 데이터 선택 -> 전처리 -> 데이터 변환 -> 데이터 마이닝 -> 해석 및 평가

데이터 마이닝의 중요성

=> 아래의 과정에서 / 과정을 위해서 데이터 마이닝을 사용함!

- 의사결정 강화 : 데이터로부터 통찰력을 얻어 전략 계획 수립

- 효율성 증대 : 비용 절감, 리스크 관리

- 고객 이해 : 고객의 요구 행동 이해, 맞춤형 서비스 제품 개발

- 시장 동향 예측

데이터 마이닝 사례

- 코로나19 데이터 마이닝

: 코로나의 흐름을 추적하기 위해 감염자 수, 회복률, 백신 접종 현황, 인구 통계학 정보 등이 사용됨

=> 백신 효과, 바이러스 추적 등 의사 결정에 활용

- 실시간 GPS 데이터를 통한 최적 교통 정보 도출

: 실시간 차량의 위치 데이터, 움직이는 물체의 속도, 이동 방향 등의 데이터 사용

=> 어떤 경로로 갈 것인지, 교통 체증 완화 전략 등 의사 결정에 활용

- 구글 검색어 기반 독감 예보

: 구글에 검색하는 유행성 질병 검색어 데이터 활용

특정 조건의 검색어 정보 활용 (시간대별, 지역별)

- DNA 데이터를 통한 범죄자 추적

: 여러 사람의 DNA 데이터베이스와 수집한 비교 대상의 DNA 유사도 분석

데이터 마이닝 프로세스

데이터 수집 및 통합

- 목적으로 하는 문제를 풀기 위한 데이터 수집

-> 다양한 분석을 위해 서로 상이한 종류의 데이터 수집 (전문가의 통찰 필요)

- 데이터 통합 과정

: 일관된 형식으로 데이터 통합

ex. 이모티콘, DOM 구조 등 제거

- 데이터 품질 관리

: 데이터 검증 및 정화(오류, 중복 수정 및 제거)

: 완결성 검사(누락 데이터 핸들링)

데이터 전처리

: 데이터를 분석하기 위한 가장 초기 과정이며 중요한 첫 단추!

- 노이즈 및 오류 제거 : 이상치 확인. 수집 과정에서의 오류 데이터 확인

- 데이터 정규화 : 데이터의 스케일 통합

- 등

데이터 마이닝 기법 적용

-> 데이터 마이닝은 하나의 데이터에만 타겟팅한 주제가 아님!!

즉, 어떤 데이터를 어떻게 사용할 것인지 모두 다름

=> 수집한 데이터에 특화된 데이터 분석 방법론 적용

-> 비슷한 데이터 분석 사례 확인

ex. Kaggle에서 비슷한 데이터를 찾아서 분석한 선례를 찾아봄

* 주로 사용하는 마이닝 기법은

분류, 클러스터링, 예측, 잠재적 의미 표면화 등

결과 분석

데이터를 통해 인사이트를 얻고, 이를 바탕으로 의사 결정과 같은 과정에 사용

주의할 점은..

모델 평가 과정 시 모델을 평가하는 평가 수치가 의사 결정에 도움이 되는 평가인지 판단,

평가한 데이터가 의미 있는 데이터인지 확인 필요!

평가과정없이 사람의 직관과 판단이 들어가야 한다면, 원본 데이터에 편향이 없는지, 그 직관에 위험성은 없는지 등 고려 필요

데이터 웨어하우스

대기업에서 데이터를 관리할 때, 다양한 부서 존재

-> 이때마다 데이터 호출 인터페이스를 각각 따로 만든다면 너무 많은 비용 필요

-> 이렇게 데이터의 흐름이 엉켜있는 형태를 거미집 현상(Spider Web)이라고 함!

=> 이걸 효율적으로 컨트롤할 수 있는 것이 데이터 웨어하우스 (데이터가 모이는 창고)

데이터 웨어하우스에 저장하는 것

: 조직이 수집한 모든 데이터 (과거의 정보도 포함)

정형 데이터 + 비정형 데이터

ex. 원천 데이터, 사용 로그, 모델 학습에 쓰일 전처리된 데이터 등

데이터 웨어하우스 (DW) VS 데이터 베이스 (DB)

데이터 베이스 (DB)

: 실시간 데이터 처리와 트랜잭션 관리에 중점을 둠

: 일상적인 업무 및 응용 프로그램에 필요한 현재의 데이터를 저장 및 관리

-> 데이터의 신속한 read와 write의 목적

- 데이터 소비처 or 생산처에서 만들어지고 관리

- 다수의 사용자들이 동시 사용 가능

데이터 웨어하우스 (DW)

: 대규모 데이터를 통합, 분석, 보고하며, 과거의 데이터도 포함하고 있음

- DB의 데이터가 주기적으로 모여 만들어짐

- 조직 내 특정 그룹의 사용자에게만 제한

데이터 웨어하우스의 구성 요소

ETL (Extract, Transform, Load)

- Extract : 원천 데이터에서 데이터 추출

- Transform : 저장할 형태에 맞춰 변형

- Load : 중앙 데이터 저장소로 적재

중앙 데이터 저장소

: ETL된 데이터가 쌓이는 저장소

메타 데이터

: 데이터가 어디에서 왔는지, 어디에 저장되었는지 등 추가 정보

원천 데이터의 장소, 중앙 데이터 저장소의 크기 및 구성 방법 등

접근

: 사용자의 데이터 저장소와의 상호작용 지원

데이터 마트 (Data Mart)

데이터 웨어하우스에서는 요청에 맞는 작은 데이터 집합을 제공

-> 이를 데이터 마트라고 함

(데이터 웨어하우스에는 접근할 수 없지만, 과거의 데이터를 보고 싶어하는 사람들에게 제공)

데이터 마트의 특징

- 부서 중심적 & 주제 중심적

: 특정 부서나 특정 주제에 맞춰 데이터가 설계됨

: 항상 준비된 것이 아니라 주제에 맞는 부서의 요청이 있을 때 만들어짐

- 데이터 집중도가 높아짐

: 관련 있는 데이터만 집중적으로 포함

: 사용자 그룹이 필요로 하는 정보를 빠르고 쉽게 확인 가능

- 효율적 운영 및 사용자 친화성

: 필요한 데이터에 대해서 분석 진행 가능

'STUDY > DevCourse' 카테고리의 다른 글

| [데브코스][데이터 분석] 추천 시스템과 추천 시스템 알고리즘 (1) | 2024.05.16 |

|---|---|

| [데브코스][데이터 분석] 데이터 마이닝 실습 (0) | 2024.05.16 |

| [데브코스][데이터 분석] 딥러닝 모델을 활용한 문장 분류 실습 (1) | 2024.05.15 |

| [데브코스][데이터 분석] 자연어 처리 & 문장 분류 (0) | 2024.05.15 |

| [데브코스][데이터 분석] 토픽 모델링과 워드 클라우드 (1) | 2024.05.15 |